Noticia Anterior

Trayendo la Inteligencia Artificial para nuestras vidas con Intel.

Escrito el 30 ago 2016

Comment: 0

El camino para la Inteligencia Artificial

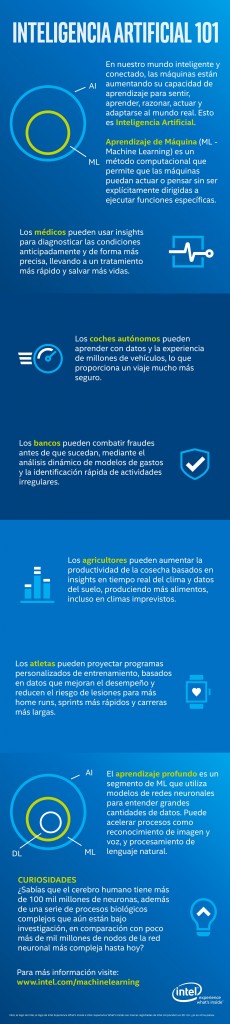

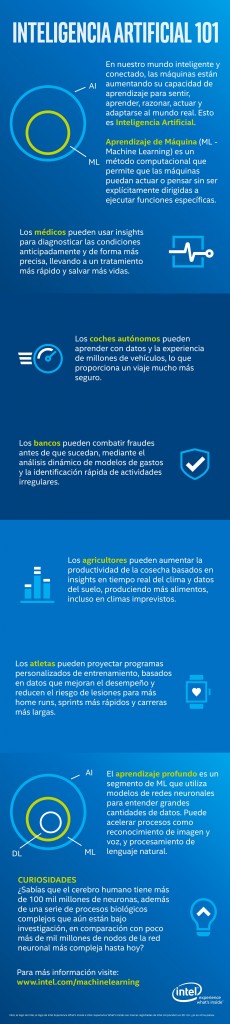

La Inteligencia Artificial (IA) puede parecer cosa de un futuro lejano, pero en realidad, está a nuestro alrededor con el creciente número de máquinas empezando a sentir, aprender, razonar, actuar y adaptarse al mundo real. Eso está transformando industrias y cambiando nuestras vidas de maneras increíblemente nuevas al amplificar la capacidad humana, automatizar tareas tediosas o peligrosas, y resolver algunos de nuestros problemas sociales más difíciles.

Aprendizaje automático

Aprendizaje automático

Si bien menos del 10 por ciento de los servidores en todo el mundo fueron desplegados para apoyar el aprendizaje automático el año pasado, esa área de la Inteligencia Artificial tiene el más rápido crecimiento y es un método computacional clave para ampliar el campo de la IA. En esencia, el aprendizaje automático es el uso de algoritmos informáticos para realizar predicciones basadas en datos, permitiendo que máquinas actúen o piensen sin ser dirigidas explícitamente para realizar funciones específicas. La máquina es entrenada para reconocer patrones y conexiones entre datos complejos y entonces marcar o clasificar datos nuevos para realizar tareas. Actualmente, se pueden tomar semanas para entrenar modelos de aprendizaje automático, impidiendo que modelos tengan la capacidad de aprender a partir de nuevos datos e información en tiempo real. Sin embargo, con la explosión de datos en nuestro mundo más conectado y más inteligente a partir del cual los modelos pueden aprender con el mayor poder de cálculo, los modelos de aprendizaje automático se están convirtiendo en mucho más precisos y útiles. Hoy en día, los procesadores Intel equipan 97 por ciento de los servidores desplegados para apoyar las cargas de trabajo de aprendizaje automático.

Aprendizaje profundo

Aprendizaje profundo, una rama del aprendizaje automático, es un campo incipiente y de rápido crecimiento. El aprendizaje profundo utiliza redes neuronales para entender datos más complejos y no estructurados, y está produciendo avances en áreas como reconocimiento de imágenes, reconocimiento de voz, procesamiento del lenguaje natural y otras tareas complejas. El aprendizaje profundo emula las neuronas y sinapsis en el cerebro, aprendiendo a través de la repetición y de la formación de vías complejas en una red neuronal. Muchos de nosotros ya se benefician de estos algoritmos, que se utilizan en las funciones de reconocimiento facial y etiquetas en las redes sociales, reconocimiento de voz en nuestros teléfonos inteligentes, control de vehículos semiautónomos y muchas más aplicaciones.

Tecnologías de Intel para aprendizaje automático

Para aprender y trabajar con rapidez, el aprendizaje automático requiere gran capacidad computacional para ejecutar algoritmos matemáticos complejos y procesar enormes cantidades de datos. Reducir el tiempo para entrenar modelos y también acelerar la clasificación de los datos requiere un cambio de paradigma en la computación distribuida, utilizando una infraestructura de clúster robusta de múltiples nodos. Intel ofrece un modelo de programación consistente y una arquitectura común que pueden ser utilizados en la computación de alto rendimiento, análisis de datos y en cargas de trabajo de aprendizaje automático.

· Familia de procesadores Intel® Xeon Phi™ permite a los científicos de datos entrenen algoritmos complejos más rápidamente y ejecuten cargas de trabajo más variadas que las GPUs. En una infraestructura de 32 nodos, los procesadores Xeon Phi de Intel ofrecen hasta una capacidad de escala 1.38 vez mayor que las GPUs1.

· Familia de procesadores Intel® Xeon® E5 es las más ampliamente usada en inferencias de aprendizaje automático. Proporciona rendimiento comparable y costo de propiedad mejor que las GPUs, con más flexibilidad para ejecutar una amplia variedad de cargas de trabajo en los centros de datos. En combinación con FPGAs Altera Arria 10, ofrece excelente rendimiento por vatio y mayor capacidad de configuración para administrar cargas de trabajo diferentes.

· El Intel® Scalable System Framework ofrece arquitecturas completas y diseños de referencia que mejoran la interoperabilidad tecnológica y reducen la complejidad de implementación, proviendo un camino para la adopción más amplia de algoritmos distribuidos de aprendizaje profundo y una reducción significativa en el tiempo para modelaje.

· Intel firmó un acuerdo definitivo para adquirir Nervana Systems*, un reconocido líder en aprendizaje profundo. El Nervana Engine (propiedad intelectual en silicio) y el conocimiento en algoritmos de aprendizaje profundo van producir avances en la cartera de inteligencia artificial de Intel y acelerar nuestros planes para Intel Xeon/Xeon Phi.

Un enfoque abierto para aprendizaje automático

Intel trabaja activamente con la comunidad de código abierto y también ofrece una variedad de librerías y APIs para acelerar el progreso de la inteligencia artificial y ampliar el acceso a herramientas poderosas.

Optimizaciones en la estructura de aprendizaje automático

Librerías optimizadas para aprendizaje automático

Zona de desarrolladores de Intel

1 Hasta un 38 por ciento más de eficiencia de escala con 32 nodos basados en topología GoogLeNet de entrenamiento de clasificación de imagen por aprendizaje profundo utilizando una grande base de imágenes, comparando un procesador Intel Xeon Phi 7250 por nodo (16 GB, 1.4 GHz, 68 núcleos) en un sistema Intel® Server LADMP2312KXXX41, DDR4 96 GB DDR4-2400 MHz, modo quad cluster, modo de memoria flat MCDRAM, Red Hat * Enterprise Linux 6.7 , Intel® Optimized DNN Framework con 87% de eficiencia para hosts desconocidos con 32 GPUs NVIDIA Tesla * K20 cada con rendimiento de 62% (Fuente: http://arxiv.org/pdf/1511.00175v2.pdf presentando FireCaffe * con 32 NVIDIA Tesla * K20s cada (Superordenador Titan*) ejecutando GoogLeNet * en velocidad 20X sobre Caffe* con un K20 cada).

2 Hasta 30x de mejora en optimización de software basada en carga de entrenamiento CNN de cliente ejecutando en el procesador 2S Intel® Xeon® E5-2680 v3 el Berkeley Vision y la biblioteca Learning Center* (BVLC) Caffe + OpenBlas* y después ejecutando ajustado sobre Intel® Optimized Caffe (versión interna de desarrollo) + Intel® Math Kernel Library (Intel® MKL).

La Inteligencia Artificial (IA) puede parecer cosa de un futuro lejano, pero en realidad, está a nuestro alrededor con el creciente número de máquinas empezando a sentir, aprender, razonar, actuar y adaptarse al mundo real. Eso está transformando industrias y cambiando nuestras vidas de maneras increíblemente nuevas al amplificar la capacidad humana, automatizar tareas tediosas o peligrosas, y resolver algunos de nuestros problemas sociales más difíciles.

Aprendizaje automático

Aprendizaje automáticoSi bien menos del 10 por ciento de los servidores en todo el mundo fueron desplegados para apoyar el aprendizaje automático el año pasado, esa área de la Inteligencia Artificial tiene el más rápido crecimiento y es un método computacional clave para ampliar el campo de la IA. En esencia, el aprendizaje automático es el uso de algoritmos informáticos para realizar predicciones basadas en datos, permitiendo que máquinas actúen o piensen sin ser dirigidas explícitamente para realizar funciones específicas. La máquina es entrenada para reconocer patrones y conexiones entre datos complejos y entonces marcar o clasificar datos nuevos para realizar tareas. Actualmente, se pueden tomar semanas para entrenar modelos de aprendizaje automático, impidiendo que modelos tengan la capacidad de aprender a partir de nuevos datos e información en tiempo real. Sin embargo, con la explosión de datos en nuestro mundo más conectado y más inteligente a partir del cual los modelos pueden aprender con el mayor poder de cálculo, los modelos de aprendizaje automático se están convirtiendo en mucho más precisos y útiles. Hoy en día, los procesadores Intel equipan 97 por ciento de los servidores desplegados para apoyar las cargas de trabajo de aprendizaje automático.

Aprendizaje profundo

Aprendizaje profundo, una rama del aprendizaje automático, es un campo incipiente y de rápido crecimiento. El aprendizaje profundo utiliza redes neuronales para entender datos más complejos y no estructurados, y está produciendo avances en áreas como reconocimiento de imágenes, reconocimiento de voz, procesamiento del lenguaje natural y otras tareas complejas. El aprendizaje profundo emula las neuronas y sinapsis en el cerebro, aprendiendo a través de la repetición y de la formación de vías complejas en una red neuronal. Muchos de nosotros ya se benefician de estos algoritmos, que se utilizan en las funciones de reconocimiento facial y etiquetas en las redes sociales, reconocimiento de voz en nuestros teléfonos inteligentes, control de vehículos semiautónomos y muchas más aplicaciones.

Tecnologías de Intel para aprendizaje automático

Para aprender y trabajar con rapidez, el aprendizaje automático requiere gran capacidad computacional para ejecutar algoritmos matemáticos complejos y procesar enormes cantidades de datos. Reducir el tiempo para entrenar modelos y también acelerar la clasificación de los datos requiere un cambio de paradigma en la computación distribuida, utilizando una infraestructura de clúster robusta de múltiples nodos. Intel ofrece un modelo de programación consistente y una arquitectura común que pueden ser utilizados en la computación de alto rendimiento, análisis de datos y en cargas de trabajo de aprendizaje automático.

· Familia de procesadores Intel® Xeon Phi™ permite a los científicos de datos entrenen algoritmos complejos más rápidamente y ejecuten cargas de trabajo más variadas que las GPUs. En una infraestructura de 32 nodos, los procesadores Xeon Phi de Intel ofrecen hasta una capacidad de escala 1.38 vez mayor que las GPUs1.

· Familia de procesadores Intel® Xeon® E5 es las más ampliamente usada en inferencias de aprendizaje automático. Proporciona rendimiento comparable y costo de propiedad mejor que las GPUs, con más flexibilidad para ejecutar una amplia variedad de cargas de trabajo en los centros de datos. En combinación con FPGAs Altera Arria 10, ofrece excelente rendimiento por vatio y mayor capacidad de configuración para administrar cargas de trabajo diferentes.

· El Intel® Scalable System Framework ofrece arquitecturas completas y diseños de referencia que mejoran la interoperabilidad tecnológica y reducen la complejidad de implementación, proviendo un camino para la adopción más amplia de algoritmos distribuidos de aprendizaje profundo y una reducción significativa en el tiempo para modelaje.

· Intel firmó un acuerdo definitivo para adquirir Nervana Systems*, un reconocido líder en aprendizaje profundo. El Nervana Engine (propiedad intelectual en silicio) y el conocimiento en algoritmos de aprendizaje profundo van producir avances en la cartera de inteligencia artificial de Intel y acelerar nuestros planes para Intel Xeon/Xeon Phi.

Un enfoque abierto para aprendizaje automático

Intel trabaja activamente con la comunidad de código abierto y también ofrece una variedad de librerías y APIs para acelerar el progreso de la inteligencia artificial y ampliar el acceso a herramientas poderosas.

Optimizaciones en la estructura de aprendizaje automático

- En el campo de aprendizaje automático, Intel ha trabajado con la comunidad de código abierto para optimizar las estructuras estándares de la industria, como Caffe* Theano*, para que los clientes puedan contar con el rendimiento de las tecnologías Intel usando su infraestructuras existentes. Clientes que utilizan la versión optimizada de Caffe ahora son capaces de aumentar en hasta 30 veces el rendimiento en comparación con la versión tradicional ejecutada en la arquitectura Intel2.

- Intel optimizará otras estructuras para aprendizaje automático para la arquitectura Intel a finales de 2016.

Librerías optimizadas para aprendizaje automático

- Intel optimizó la ampliamente utilizada Intel® Math Kernel Library (Intel® MKL) para el aprendizaje automático, permitiendo el acceso más profundo a código optimizado a través de un conjunto estándar de API sin costo alguno.

- Intel planea liberar la Intel® Math Kernel Library – Deep Learning Neural Network (Intel® MKL-DNN), ofreciendo una implementación de código abierto de las capas de redes neuronales para aprendizaje profundo de la MKL. Esto facilitará la integración y la adopción de estructuras populares de código abierto para aprendizaje profundo.

- Las Intel® Data Analytics Acceleration Libraries (Intel® DAAL) están ahora disponibles en código abierto y van apoyar el aprendizaje profundo.

- Intel planea liberar un kit de desarrollo de software para aprendizaje profundo a finales de 2016.

Zona de desarrolladores de Intel

- La zona de desarrolladores de Intel proporciona una formación integral sobre herramientas para aprendizaje automático a más de 100.000 profesionales y continuará ampliando las oportunidades de formación en el año 2016.

- Intel ofrece a instituciones académicas seleccionadas acceso a la familia de procesadores Intel Xeon Phi para fomentar la investigación de la próxima generación de algoritmos para aprendizaje profundo.

1 Hasta un 38 por ciento más de eficiencia de escala con 32 nodos basados en topología GoogLeNet de entrenamiento de clasificación de imagen por aprendizaje profundo utilizando una grande base de imágenes, comparando un procesador Intel Xeon Phi 7250 por nodo (16 GB, 1.4 GHz, 68 núcleos) en un sistema Intel® Server LADMP2312KXXX41, DDR4 96 GB DDR4-2400 MHz, modo quad cluster, modo de memoria flat MCDRAM, Red Hat * Enterprise Linux 6.7 , Intel® Optimized DNN Framework con 87% de eficiencia para hosts desconocidos con 32 GPUs NVIDIA Tesla * K20 cada con rendimiento de 62% (Fuente: http://arxiv.org/pdf/1511.00175v2.pdf presentando FireCaffe * con 32 NVIDIA Tesla * K20s cada (Superordenador Titan*) ejecutando GoogLeNet * en velocidad 20X sobre Caffe* con un K20 cada).

2 Hasta 30x de mejora en optimización de software basada en carga de entrenamiento CNN de cliente ejecutando en el procesador 2S Intel® Xeon® E5-2680 v3 el Berkeley Vision y la biblioteca Learning Center* (BVLC) Caffe + OpenBlas* y después ejecutando ajustado sobre Intel® Optimized Caffe (versión interna de desarrollo) + Intel® Math Kernel Library (Intel® MKL).